为了避免一个网站对搜索引擎不友好,你只需要考虑一些基本的搜索引擎优化准则以及优质内容开发实践。

作为一个网站设计者,我考虑了很多我曾经遇到的和听说过的在用搜索引擎优化创建站点时遇到的问题。下面是10条非常棒的搜索引擎优化建议,它们能让你在不牺牲你的创造性和风格的情况下做出对搜索引擎更友好的网站设计。

1. 确保你的网站导航对搜索引擎友好

如果你不清楚如何让Flash对象可访问和对网络爬虫友好,那么用Flash作为网站导航是很糟糕的选择。搜索引擎很难抓取一个使用Flash的网站。

CSS和不引人注意的JavaScript能够在不牺牲你的搜索引擎排名的情况下提供任何你需要的精心设计的效果。

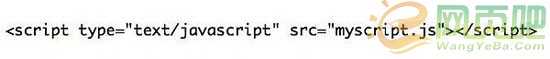

2. 把脚本放在HTML文件之外

当你为网站写代码时,要确保你以外部引用的方式使用JavaScript和CSS。

搜索引擎通过所有包含在HTML文件中的内容来查看站点。如果没有用外部引用的方式使用JavaScript和CSS,会在你的HTML文档中增加一些额外的代码行,在大多数情况下,这些代码会在真正的内容的前面从而使得爬虫爬取速度变慢。搜索引擎希望能尽可能快的获取到一个网站的内容。

3. 使用搜索引擎爬虫能阅读的内容

内容是一个网站的生命力所在,也是搜索引擎需要的。在设计一个网站时,确保你仔细考虑过内容的良好结构(如标题、段落和链接)。

内容很少的网站总是在搜索结果中“苦苦挣扎”,在多数情况下,如果在设计阶段有更合适的计划的话是完全可以避免的。例如,不要用图片来代替文字除非你使用了CSS背景图片文字替换技术。

4. 设计你的URL使其对搜索友好

对搜索友好的URL不是那些难以抓取的URL,例如查询字符串等。最好的URL包含帮助描述页面内容的关键字。要注意一些内容管理系统使用自动生成的数字和特殊的符号作为页面的URL。好的内容管理系统会让你可以定制和美化网站URL。

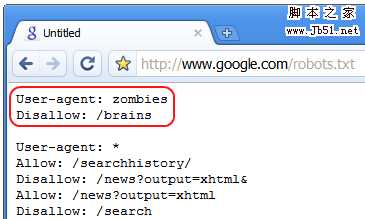

5. 限制你不希望搜索引擎索引的页面

可能会有一些你不希望搜索引擎索引到的页面。这些页面可能是对你的内容毫无用处,例如服务器端脚本。这些网页甚至可能是在你正建立新的站点时用来测试你的设计的(虽然不建议这么做,但是我们大多数人仍然会这么做)。

不要将这些页面暴露给web机器人。你可能会给搜索引擎重复的内容,同时会稀释你的主要内容。这些页面可能会对你的网站的搜索位置产生负面影响。

最好的避免这些页面被搜索引擎检索到的方法是使用robots.txt文件,能改善你的网站的五个文件之一。

如果你的网站有一部分正在测试环境中使用,用密码保护这部分内容,更好的方法是,使用本地web开发环境如XAMPP或者WampServer。

6. 不要忽视图片的Alt属性

确保你的所有图片的alt属性都是描述性的。所有的图片的alt属性必须100%符合W3C标准,但是很多都只是通过简单地添加任意的文字来达到这个要求。没有alt属性也比不正确的alt属性好。

搜索引擎会读取alt属性,并且可能会将其纳入页面与搜索关键词相关性的考虑之中。这也可能用于像Google图片这样的基于图片排名的搜索引擎。

除了搜索引擎优化的角度,图片的alt属性还可以帮助盲人用户。

7. 用新的内容更新页面

如果你的网站有博客,你可以考虑在网页上留出地方放一些最新内容的摘要。搜索引擎很希望看到网页内容不时地改变表明这个站点还是好好的。还可以通过不断变化的内容来提高搜索引擎的抓取频率。

你并不想展示完整的摘要因为这会引起重复内容的问题。

8. 使用唯一的元数据

页面标题、描述和关键字应该都不一样。很多情况下,网站设计者会创建一个网站模板,但是忘记修改元数据,最后会导致好几个页面会使用原来的占位符信息。

每个页面都应该有自己的元数据。这就是能够帮助搜索引擎更好的把握网站的结构的方法之一。

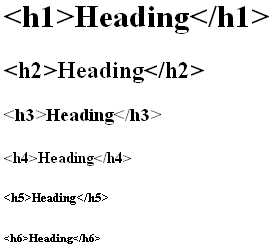

9. 恰当地使用标题标签

在你的网页内容中充分利用标题标签;它们向搜索引擎提供HTML文档的结构信息,并且他们通常相比于网页上的其它文本具有更高的权值(除了链接)。

对于页面的主题使用<h1>标签。充分利用<h2>到<h6>标签来指明内容的层次以及描述相似的内容区域。

我不主张在一个页面使用多个<h1>标签,这样你的关键主题才不会被冲淡。

10. 遵从W3C标准

搜索引擎喜欢组织得很好,整洁的代码(谁又不喜欢呢?)。整洁的代码使得网站更容易被索引,也是一个网站建得有多好的标志。

遵从W3C标准基本上就是强迫你写语义化的标签,这对于SEO来说只有百利而无一害的。

免责声明:本站资源来自互联网收集,仅供用于学习和交流,请遵循相关法律法规,本站一切资源不代表本站立场,如有侵权、后门、不妥请联系本站删除!

稳了!魔兽国服回归的3条重磅消息!官宣时间再确认!

昨天有一位朋友在大神群里分享,自己亚服账号被封号之后居然弹出了国服的封号信息对话框。

这里面让他访问的是一个国服的战网网址,com.cn和后面的zh都非常明白地表明这就是国服战网。

而他在复制这个网址并且进行登录之后,确实是网易的网址,也就是我们熟悉的停服之后国服发布的暴雪游戏产品运营到期开放退款的说明。这是一件比较奇怪的事情,因为以前都没有出现这样的情况,现在突然提示跳转到国服战网的网址,是不是说明了简体中文客户端已经开始进行更新了呢?